สรุปข่าว

ปัญญาประดิษฐ์ หรือ AI (Artificial Intelligence) ได้เข้ามาปฏิวัติวงการวิทยาศาสตร์ในปัจจุบัน เพราะช่วยอำนวยความสะดวกในการทำงานต่าง ๆ โดยเฉพาะบทบาทในด้านการแพทย์ที่นำ AI มาใช้เพื่อช่วยวินิจฉัยและรักษาโรคได้อย่างแม่นยำมากขึ้น

ที่มาของภาพ Unsplash

ที่มาของภาพ Unsplash

ล่าสุด นักวิจัยจากมหาวิทยาลัยฮาร์วาร์ดได้พัฒนา AI ที่สามารถเรียนรู้การแปลผลและวินิจฉัยโรคจากภาพถ่ายรังสีเอกซเรย์ได้ด้วยตนเอง โดยไม่จำเป็นต้องผ่านการระบุข้อมูลทีละขั้นตอน (Labeling) จากรังสีแพทย์ จึงเพิ่มความรวดเร็วในการเรียนรู้และลดค่าใช้จ่ายในการพัฒนาได้อย่างมหาศาล

การพัฒนา AI ให้สามารถวิเคราะห์ภาพถ่ายรังสีเอกซเรย์นั้น โดยปกติแล้ว AI จะต้องเรียนรู้ชุดข้อมูลที่จำเป็นต่อการแปลผล ซึ่งชุดข้อมูลที่สำคัญในการสอน AI ให้แปลผลภาพถ่ายรังสี คือ ลักษณะของรอยโรคต่าง ๆ เพื่อใช้ในการวินิจฉัยแยกโรคที่เป็นไปได้จากภาพถ่ายรังสีนั้น ๆ

ที่มาของภาพ Unsplash

ที่มาของภาพ Unsplash

ก่อนหน้านี้ นักพัฒนาจะต้องนำข้อมูลที่มีการระบุข้อมูล (Labeling) ป้อนเข้าไปให้ AI ได้เรียนรู้ เป็นต้นว่า หากต้องการให้ AI แปลผลและวินิจฉัยภาพถ่ายรังสีเอกซเรย์ปอดของผู้ป่วยวัณโรค รังสีแพทย์ที่ร่วมพัฒนาจะต้องเตรียมภาพถ่ายรังสีของผู้ป่วยวัณโรคปอด พร้อมทั้งระบุข้อมูลรอยโรคต่าง ๆ ที่ปรากฏบนภาพถ่ายก่อนที่จะป้อนข้อมูลเหล่านั้นให้แก่ AI

ซึ่งการระบุข้อมูลจะต้องทำแบบภาพต่อภาพ เพราะในแต่ละภาพอาจมีลักษณะหรือตำแหน่งของรอยโรคที่แตกต่างกัน และการฝึกสอน AI ต้องใช้ภาพถ่ายจำนวนมาก (อาจมากถึง 10,000 ภาพ) เพื่อให้ AI สามารถวิเคราะห์ได้อย่างแม่นยำ ยิ่งมีการระบุรอยโรคได้ละเอียดมากเท่าใด AI ก็จะมีความแม่นยำมากเท่านั้น

ที่มาของภาพ Unsplash

ที่มาของภาพ Unsplash

ทว่า กระบวนการระบุข้อมูลทีละภาพจากภาพถ่ายจำนวน 10,000 ภาพ ต้องใช้ทรัพยากรทั้งเวลา, บุคคล และค่าใช้จ่ายเป็นจำนวนมาก ในระยะหลังจึงมีการปรับเปลี่ยนให้ AI ได้เห็นภาพถ่ายรังสีเอกซเรย์ที่หลากหลายก่อน โดยไม่จำเป็นต้องระบุข้อมูลในช่วงแรก (เรียกว่าข้อมูลไร้โครงสร้าง หรือ Unstructured data) ส่งผลให้ AI ได้เรียนรู้ภาพถ่ายได้อย่างรวดเร็ว แต่สุดท้ายพวกมันจะยังไม่รู้จักวิธีการแปลผลและวินิจฉัย จนกว่าจะมีการระบุข้อมูลรอยโรคต่าง ๆ ให้อีกทีหนึ่ง

นั่นหมายความว่า ไม่ว่าจะเป็นการระบุข้อมูลให้กับ AI ตั้งแต่เริ่มต้น หรือการปล่อยให้ AI ได้เรียนรู้ภาพก่อนแล้วมาระบุข้อมูลภายหลัง ต่างก็ทำให้เกิดความล่าช้าในการพัฒนา AI ด้วยกันทั้งสิ้น เพราะสุดท้ายแล้วรังสีแพทย์จะต้องเป็นผู้ระบุรายละเอียดของข้อมูลที่จำเป็นในการวิเคราะห์ภาพอยู่ดี

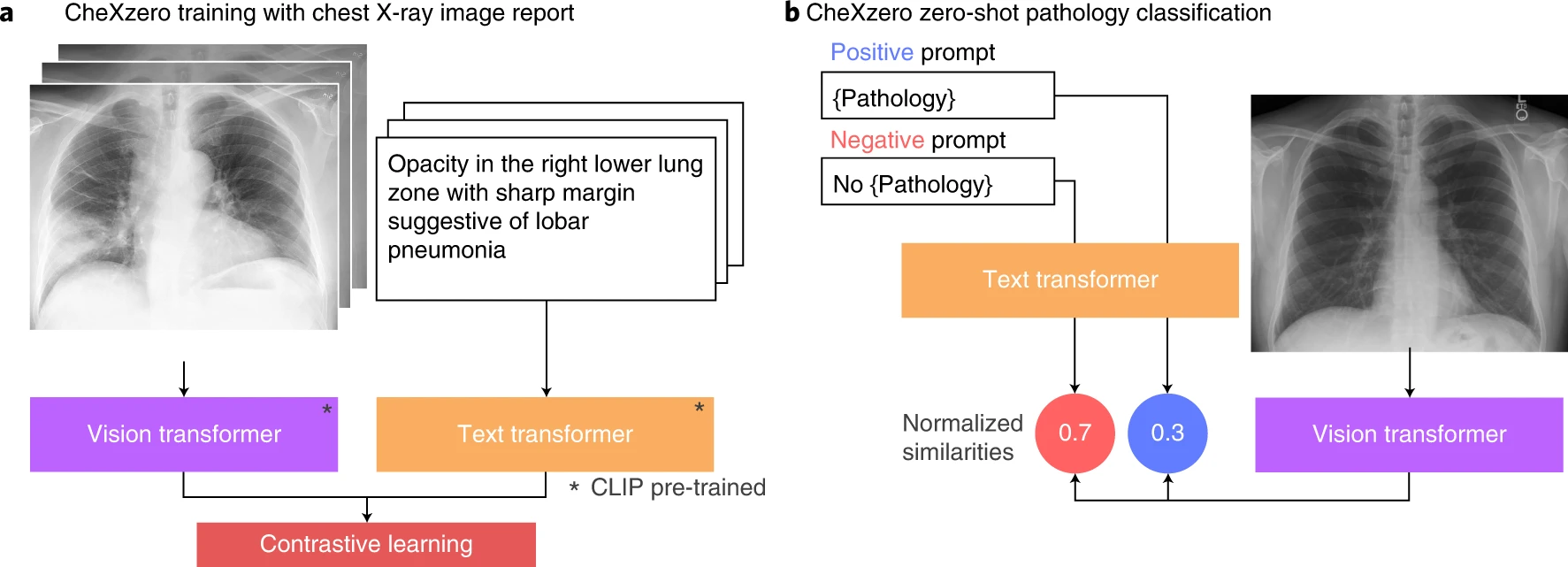

ด้วยเหตุนี้นักวิจัยจากมหาวิทยาลัยฮาร์วาร์ดจึงได้พัฒนา AI ที่มีชื่อว่า CheXZero (เช็กส์ซีโร) ซึ่งแตกต่างไปจากรูปแบบของ AI ที่กล่าวไว้ในข้างต้น คือ CheXZero จะอาศัยแค่ภาพถ่ายรังสีเอกซเรย์และผลอ่านที่เตรียมไว้แล้ว เนื่องจากโดยปกติแล้วรังสีแพทย์จะรายงานการอ่านผลและการวินิจฉัยสำหรับผู้ป่วยแต่ละรายไว้ในเอกสารทางการแพทย์ ดังนั้น ข้อมูลที่จะป้อนให้ AI เป็นข้อมูลที่มีอยู่ดั้งเดิมแล้วจึงช่วยลดระยะเวลาในการฝึกสอน AI ได้มากเลยทีเดียว

ที่มาของภาพ Nature

ที่มาของภาพ Nature

หลังจากที่ได้ภาพถ่ายรังสีและผลอ่านมาแล้ว CheXZero จะทำหน้าที่แปลความหมายของผลอ่าน แล้วนำไปวิเคราะห์หารอยโรคในภาพถ่ายรังสีด้วยตัวเองเพื่อเก็บสะสมข้อมูลเหล่านั้นไว้ นั่นหมายความว่า CheXZero สามารถ "ระบุข้อมูล" ได้ด้วยตนเอง โดยไม่ต้องพึ่งพาการระบุข้อมูลทีละส่วนจากรังสีแพทย์ จากนั้นจึงนำข้อมูลของภาพถ่ายและรอยโรคที่คล้ายคลึงกันไปจัดหมวดหมู่แยกแต่ละโรคไว้

เมื่อถึงเวลาใช้งาน แพทย์จะป้อนภาพที่ต้องการให้ CheXZero ช่วยแปลผลและวินิจฉัยเข้าไป เจ้า CheXZero ก็จะวิเคราะห์รอยโรคในภาพแล้วนำไปเปรียบเทียบข้อมูลที่มีอยู่ หากตรงกับโรคใด AI จึงจะรายงานผลอ่านภาพถ่ายที่ถูกต้องพร้อมให้คำวินิจฉัยโรคออกมานั่นเอง

ที่มาของภาพ Unsplash

ที่มาของภาพ Unsplash

จากการทดสอบของนักวิจัยพบว่า CheXZero สามารถแปลผลภาพถ่ายรังสีเอกซเรย์สามารถระบุรอยโรคได้อย่างแม่ยำ และเหนือกว่า AI วิเคราะห์ภาพถ่ายรังสีเอกซเรย์อื่น ๆ ซึ่งนักวิจัยมีแผนที่จะวิธีการฝึกสอนนี้ไปใช้พัฒนา AI ในการอ่านผลภาพถ่ายรังสีคอมพิวเตอร์ (CT Scan) และภาพถ่ายคลื่นไฟฟ้าแม่เหล็ก (MRI) พร้อมทั้งเปิดให้ผู้ที่สนใจสามารถนำโค้ดไปพัฒนาต่อได้ด้วย

ขอขอบคุณข้อมูลจาก Harvard University

ที่มาข้อมูล : -